Motivations

Contexte

Contrairement aux microphones traditionnels, qui s’appuient sur les transmission des ondes sonores aériennes produites par un locuteur, les microphones à conduction corporelle captent les signaux vocaux directement à partir de la transmission vibratoire dans le corps humain, ce qui offre des avantages dans les environnements bruyants en éliminant l’influence du bruit ambiant. Bien que les microphones à conduction corporelle soient disponibles depuis des décennies, leur bande passante limitée a restreint leur utilisation à grande échelle. Toutefois, grâce à deux séries d’améliorations, cette technologie pourrait être présentée à un large public pour la capture de la parole et la communication dans les environnements bruyants.

Recherche et développement technologique

D’une part, le développement de la recherche sur les aspects physiques et électroniques s’améliore avec certains capteurs à fixer sur la peau. Comme les microphones osseux et phonatoires précédents, ces nouveaux capteurs portables détectent l’accélération de la peau, qui est fortement et linéairement corrélée à la pression vocale. Ils améliorent l’état de l’art en ayant une sensibilité supérieure sur la gamme de fréquences vocales, ce qui contribue à améliorer le rapport signal/bruit, et ont également une conformité cutanée supérieure, ce qui facilite l’adhésion aux surfaces cutanées incurvées. Cependant, ils ne peuvent pas capter toute la bande passante du signal vocal en raison du filtrage passe-bas inhérent aux tissus. Ils ne sont pas encore disponibles à l’achat car le processus de fabrication doit être stabilisé.

Deep Learning

D’autre part, les méthodes d’apprentissage profond ont montré des performances exceptionnelles dans un large éventail de tâches et peuvent surmonter ce dernier inconvénient. Pour l’amélioration de la parole, des travaux ont permis de régénérer les moyennes et hautes fréquences à partir des basses fréquences. Pour la reconnaissance vocale robuste, des modèles comme Whisper ont repoussé les limites des signaux utilisables.

La nécessité d’un ensemble de données ouvertes à des fins de recherche

La disponibilité d’ensembles de données à grande échelle joue un rôle essentiel dans l’avancement de la recherche et du développement en matière d’amélioration et de reconnaissance de la parole à l’aide de microphones à conduction corporelle. Ces ensembles de données permettent aux chercheurs d’entraîner et d’évaluer des modèles d’apprentissage profond, qui ont été l’ingrédient clé manquant pour obtenir une parole intelligible et de haute qualité avec de tels microphones. De tels ensembles de données font encore défaut. Le plus important est le corpus ESMB corpus, qui représente 128 heures d’enregistrements, mais n’utilise qu’un microphone à conduction osseuse. Il existe d’autres ensembles de données privés, mais ils sont trop limités et ne sont pas libres d’accès.

Personnes

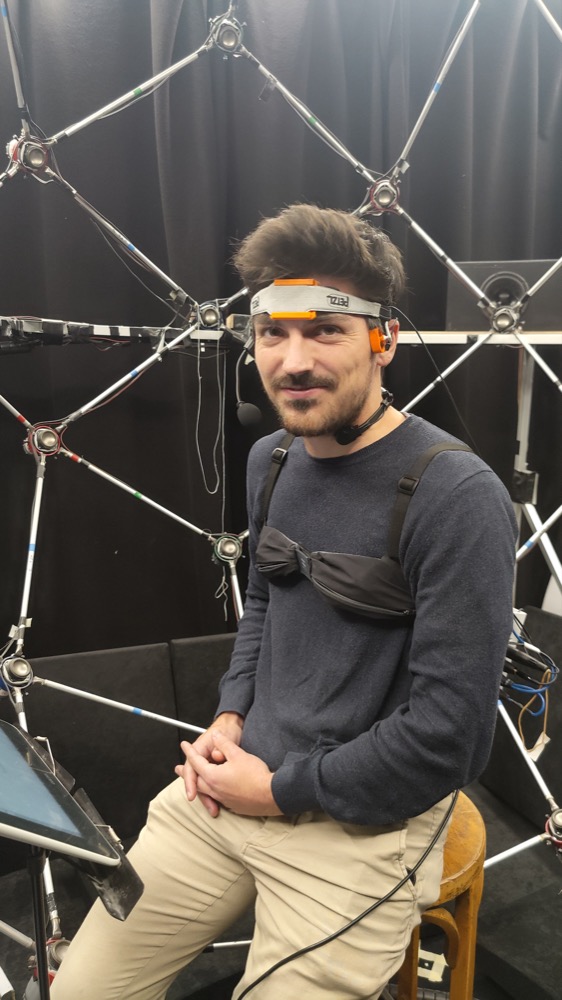

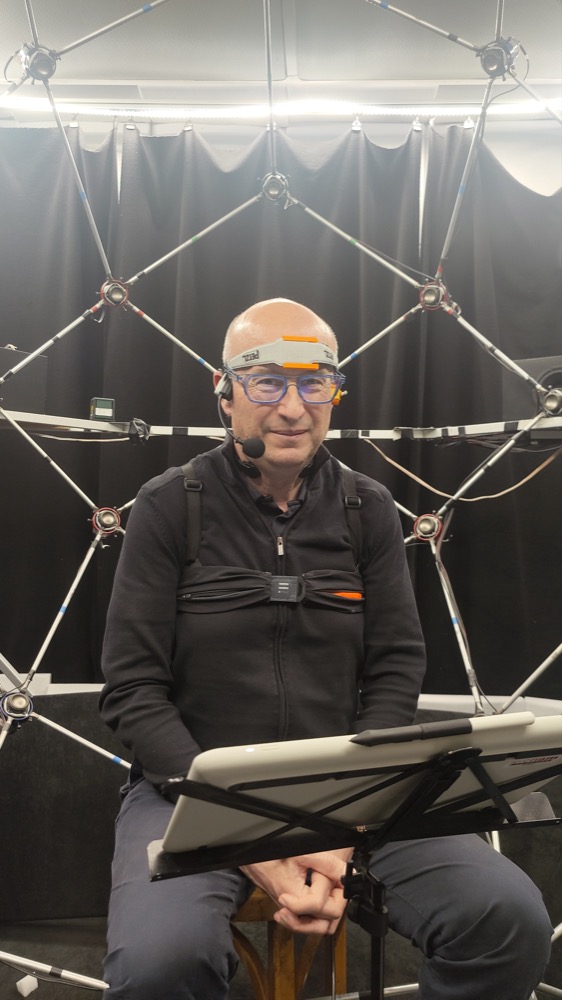

Julien HAURET

Bio

est doctorant au Cnam Paris, poursuivant des recherches en apprentissage automatique appliqué au traitement de la parole. Il est titulaire de deux masters de l’ENS Paris Saclay, l’un en génie électrique (2020) et l’autre en mathématiques appliquées (2021). Sa formation à la recherche est attestée par ses expériences à l’Université de Columbia, au ministère français des Forces armées et à la start-up Pulse Audition. De plus, il a enseigné pendant deux années consécutives les algorithmes et les structures de données à l’École des Ponts ParisTech. Ses recherches portent sur l’utilisation de l’apprentissage profond pour l’amélioration de la parole appliquée à la parole enregistrée par conduction corporelle. Passionné par la collaboration interdisciplinaire, Julien vise à améliorer la communication humaine grâce à la technologie.

Rôle

Co-coordinateur du projet. A mis en œuvre le logiciel d’enregistrement et conçu la procédure d’enregistrement. A co-conçu le site web. Responsable de la conformité au GDPR. A participé à la sélection des microphones. A dirigé la tâche d’amélioration de la parole, a coordonné la reconnaissance automatique de la parole et a apporté son soutien à la tâche de vérification du locuteur. Contributeur principal et responsable de l’enregistrement des participants. A supervisé le projet GitHub. Co-gestion de la création de l’ensemble de données, du processus de post-filtrage et du téléchargement vers HuggingFace, ainsi que de la mise en œuvre de la solution retenue. Responsable de l’entraînement des modèles sur le HPC Jean-Zay et de leur téléchargement/documentation sur le Hugging Face Hub. Principal contributeur à l’article de recherche.

Éric BAVU

Bio

Est professeur d’acoustique et de traitement du signal au Laboratoire de mécanique des structures et des systèmes couplés (LMSSC) du Conservatoire national des arts et métiers (Cnam), à Paris, en France. Il a effectué ses études de premier cycle à l’École normale supérieure de Cachan, en France, de 2001 à 2005. En 2005, il a obtenu une maîtrise en acoustique, traitement du signal et informatique appliquée à la musique à l’Université Pierre et Marie Curie Sorbonne Université (UPMC), suivie d’un doctorat en acoustique décerné conjointement par l’Université de Sherbrooke, Canada, et l’UPMC, France, en 2008. Il a également mené des recherches post-doctorales sur l’imagerie des tissus mous biologiques à l’Institut Langevin de l’École supérieure de physique et chimie ParisTech (ESPCI), en France. Depuis 2009, il a supervisé six doctorants au LMSSC, en se concentrant sur le traitement des signaux audio dans le domaine temporel pour les problèmes inverses, l’audio 3D et l’apprentissage profond pour l’audio. Ses recherches actuelles portent sur les méthodes d’apprentissage profond appliquées aux problèmes inverses en acoustique, la localisation et le suivi des sources sonores en mouvement, l’amélioration de la parole et la reconnaissance vocale.

Rôle

Co-coordinateur du projet. Responsable de la sélection, de l’étalonnage et du réglage des microphones. Co-conception du site web. Mise en œuvre du backend pour la spatialisation du son. Coordination des tâches de reconnaissance automatique de la parole et de vérification du locuteur. Aide à l’enregistrement des participants. Co-gestion de la création de l’ensemble de données, du processus de post-filtrage et du téléchargement sur HuggingFace. Contributeur GitHub. A produit la Dataset Card HuggingFace. Principal contributeur à l’article de recherche.

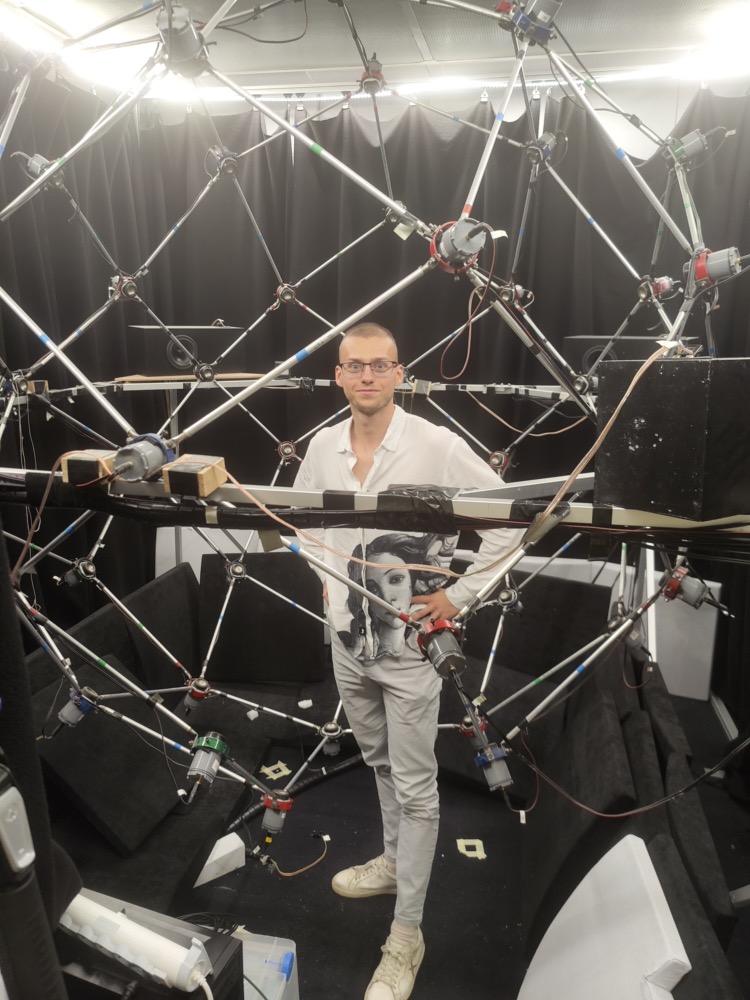

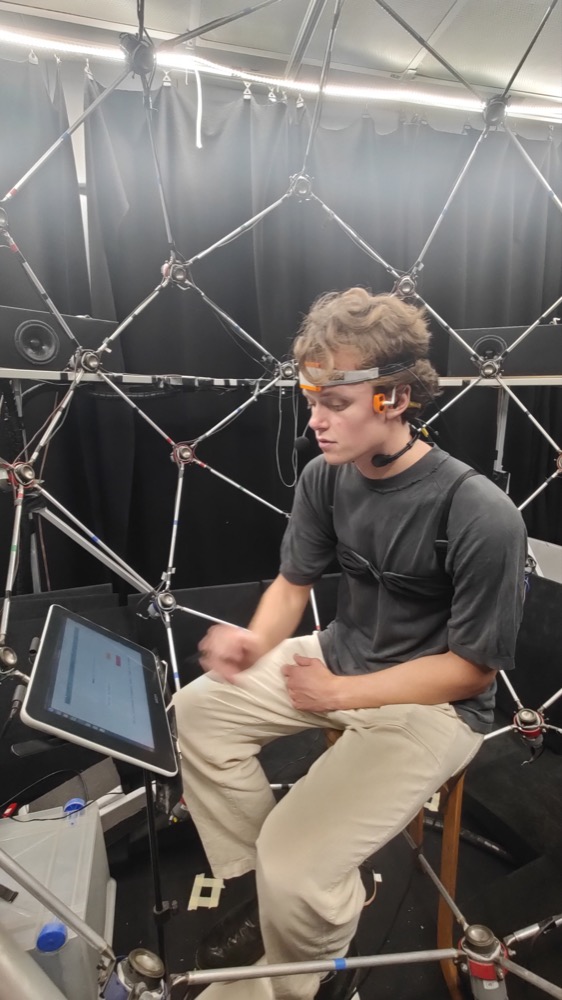

Malo OLIVIER

Bio

Est élève-ingénieur à l’INSA de Lyon, anciennement en stage au Laboratoire de Mécanique des Structures et des Systèmes Couplés (LMSSC) du Conservatoire National des Arts et Métiers (CNAM), Paris, France. Il poursuit ses études supérieures au département d’informatique de l’INSA de Lyon, où il obtiendra son diplôme en 2024. Malo possède des compétences précieuses dans la mise en œuvre de différentes solutions allant des problématiques de systèmes d’information aux architectures de réseaux neuronaux profonds, en passant par les applications web. Il envisage de poursuivre un doctorat en intelligence artificielle, en se spécialisant dans les réseaux de neurones profonds appliqués aux domaines scientifiques et espère que son profil d’ingénieur mettra en évidence ses capacités de mise en œuvre dans le cadre de projets de grand intérêt.

Rôle

Contribution essentielle à l’enregistrement des participants. Aide à l’exploration de la tâche de reconnaissance automatique de la parole, à la création de l’ensemble de données, au processus de post-filtrage et au téléchargement sur HuggingFace. Contributeur GitHub. Contribution au processus de révision de l’article de recherche.

Thomas JOUBAUD

Bio

Est chercheur associé au département Acoustique et protection du soldat au sein de l’Institut franco-allemand de recherche de Saint-Louis (ISL), France, depuis 2019. En 2013, il a obtenu le diplôme d’études supérieures de l’École centrale de Marseille, France, ainsi que le master en mécanique, physique et ingénierie, spécialisé dans la recherche acoustique, de l’Université d’Aix-Marseille, France. Il a obtenu le doctorat en mécanique, spécialité acoustique, du Conservatoire national des arts et métiers (Cnam), Paris, France, en 2017. La thèse a été réalisée en collaboration avec et au sein de l’ISL. De 2017 à 2019, il a travaillé en tant qu’ingénieur de recherche post-doctorant au sein de la société Orange SA à Cesson-Sévigné, en France. Ses recherches portent sur le traitement du signal audio, la protection auditive, la psychoacoustique, en particulier l’intelligibilité de la parole et la localisation des sons, et la mesure des bruits continus et impulsionnels de haut niveau.

Rôle

Assistance à la sélection des microphones. Co-coordination de la tâche de vérification du locuteur. Contributeur GitHub. Contribution au processus de révision de l’article de recherche.

Christophe LANGRENNE

Bio

est chercheur scientifique au Laboratoire de Mécanique des Structures et des Systèmes Couplés (LMSSC) du Conservatoire National des Arts et Métiers (Cnam), Paris, France. Après avoir obtenu son doctorat sur la régularisation des problèmes inverses, il a développé un algorithme de méthode multipolaire rapide (FMM) pour résoudre des problèmes de diffusion et de propagation à grande échelle. Également intéressé par l’audio 3D, il a co-encadré 3 doctorants sur ce thème, en particulier sur l’Ambisonic (enregistrement et décodage) et la restitution binaurale (confusions avant/arrière).

Rôle

Participation au réglage du microphone. A contribué à l’enregistrement des participants. Contribution au processus de révision de l’article de recherche.

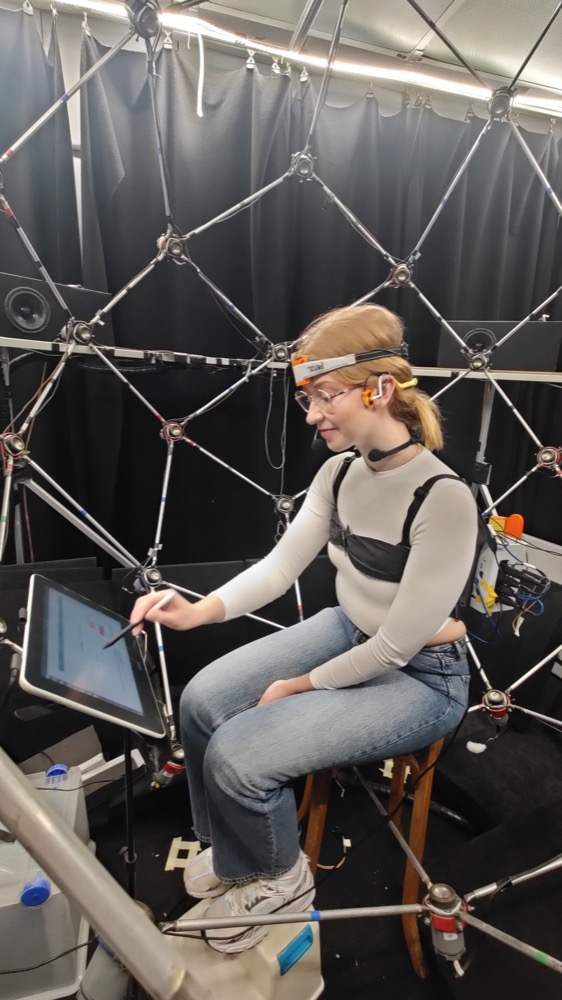

Sarah POIRÉE

Bio

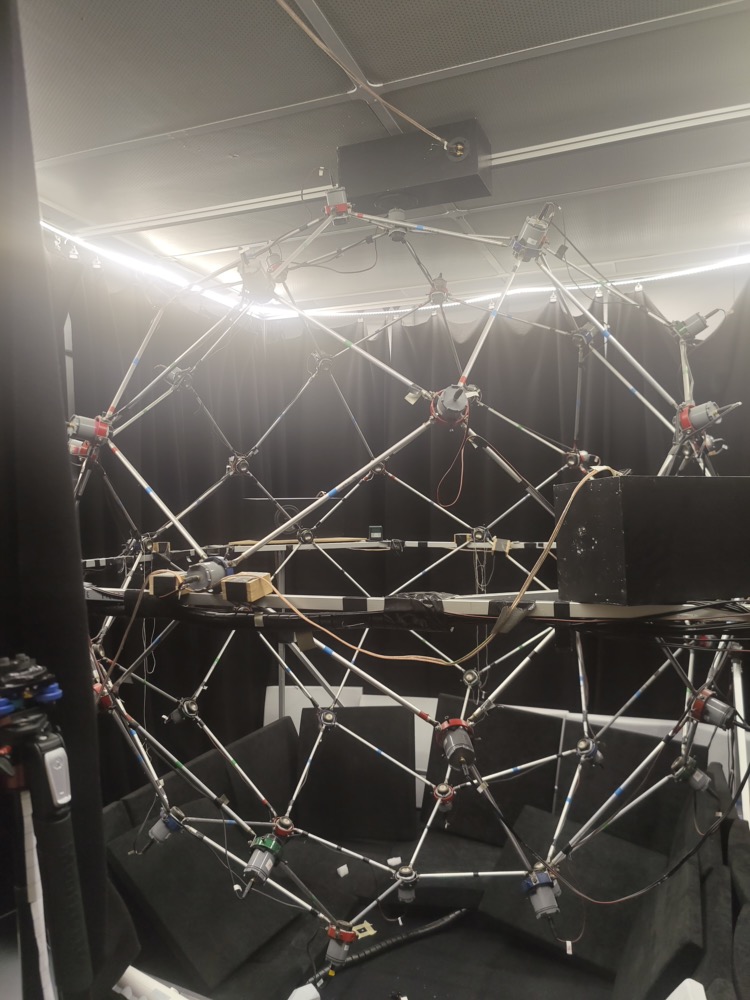

est technicienne au Laboratoire de Mécanique et des Systèmes Couplés (LMSSC) au sein du Conservatoire National des Arts et Métiers (Cnam), Paris, France. Ses activités portent sur la conception et le développement de dispositifs expérimentaux. Elle a notamment contribué à la création du système de spatialisation sonore 3D utilisé lors de l’enregistrement de l’ensemble de données Vibravox.

Rôle

A contribué à l’enregistrement des participants. Contribution au processus de révision de l’article de recherche.

Véronique ZIMPFER

Bio

Est chercheuse scientifique au département Acoustique et protection du soldat de l’Institut franco-allemand de recherche de Saint-Louis (ISL), Saint-Louis, France, depuis 1997. Elle est titulaire d’une maîtrise en traitement du signal de l’INP de Grenoble (France) et a obtenu un doctorat en acoustique de l’INSA de Lyon (France) en 2000. Son expertise se situe à l’intersection de la communication dans les environnements bruyants et de la protection auditive. Ses recherches portent sur l’amélioration des protecteurs auditifs adaptatifs, le perfectionnement des stratégies de communication radio grâce à des méthodes de microphone non conventionnelles et l’amélioration de la perception auditive lors de l’utilisation d’équipements de protection.

Rôle

Aide à la sélection des microphones. Contribution au processus de révision de l’article de recherche.

Philippe CHENEVEZ

Bio

Philippe Chenevez est un professionnel de l’audiovisuel et de l’acoustique, diplômé de l’École Louis Lumière en 1984 avec un BTS en audiovisuel, et ingénieur en acoustique du CNAM en 1996. Il a occupé le poste de Directeur technique à la société VDB de 1990 à 1998, où il s’est spécialisé en électronique HF et BF, axé sur la maintenance et le développement. En 2006, il a fondé CINELA, une entreprise de renom dans la fabrication de protections anti-vent et anti-vibratoires pour microphones de prise de son, contribuant ainsi de manière significative à l’industrie audiovisuelle grâce à ses produits innovants.

Rôle

Responsable de la préamplification des microphones.

Jean-Baptiste DOC

Bio

a obtenu son doctorat en acoustique à l’université du Mans, en France, en 2012. Il est actuellement professeur associé au Laboratoire de Mécanique des Structures et des Systèmes Couplés, Conservatoire National des Arts et Métiers, Paris, France. Ses recherches portent sur la modélisation et l’optimisation des guides d’ondes de forme complexe, leur rayonnement acoustique et l’analyse des mécanismes de production du son dans les instruments à vent.

Rôle

A participé au maintien en position des microphones.