Sous-sections de Documentation

Matériel

Parcourez tous les détails du matériel utilisé pour le projet Vibravox.

Sous-sections de Matériel

Capteurs audio

Parcourez tous les capteurs utilisés pour le projet VibraVox.

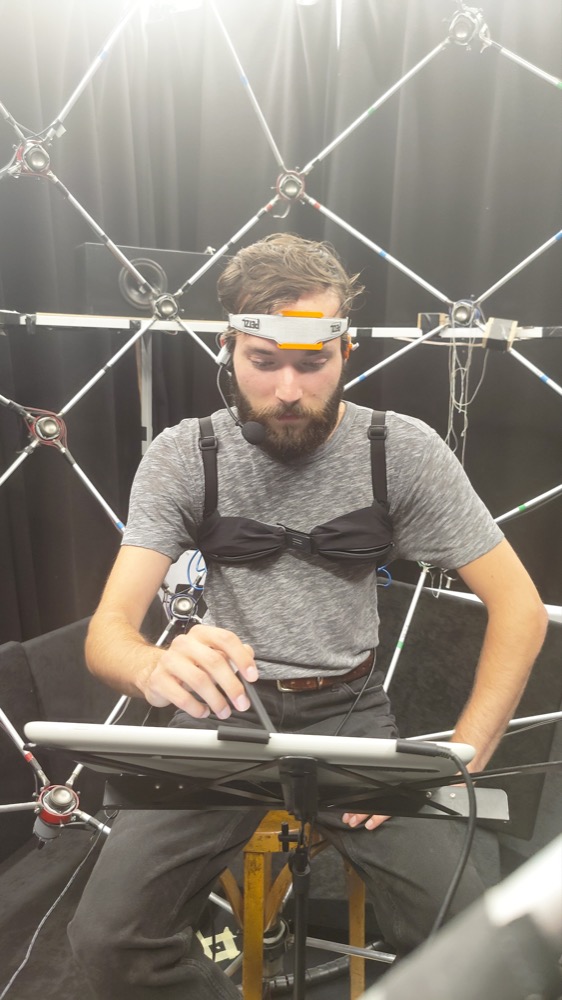

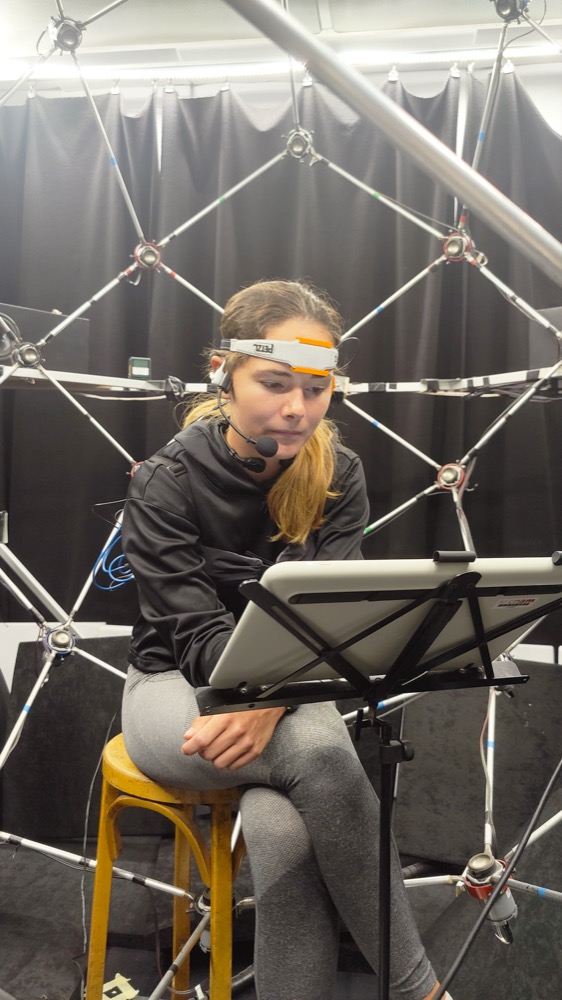

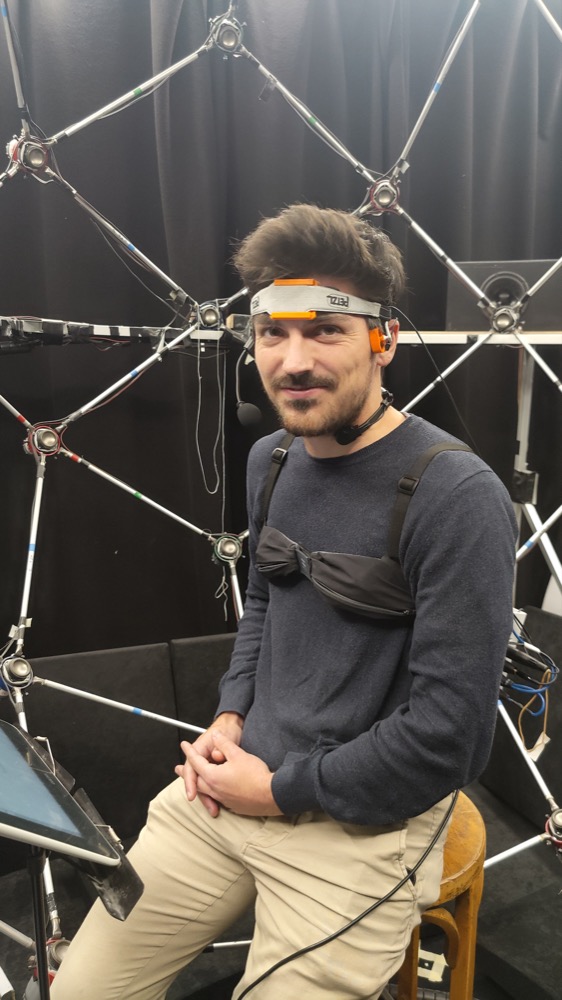

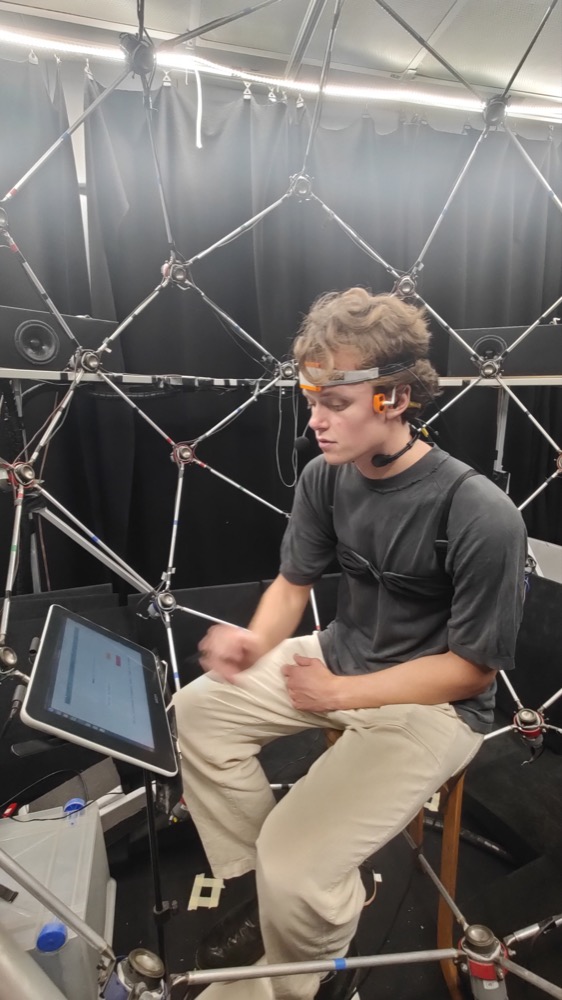

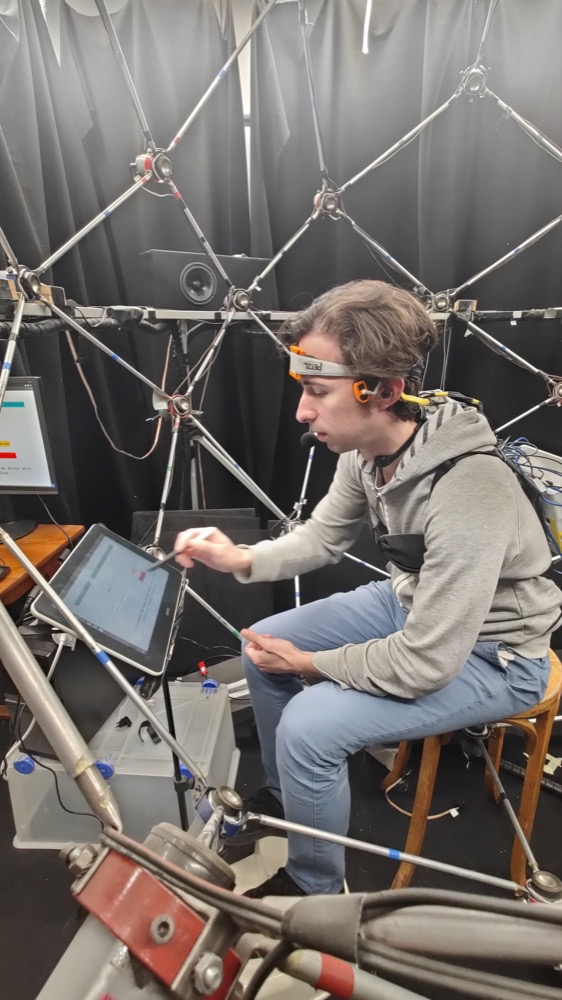

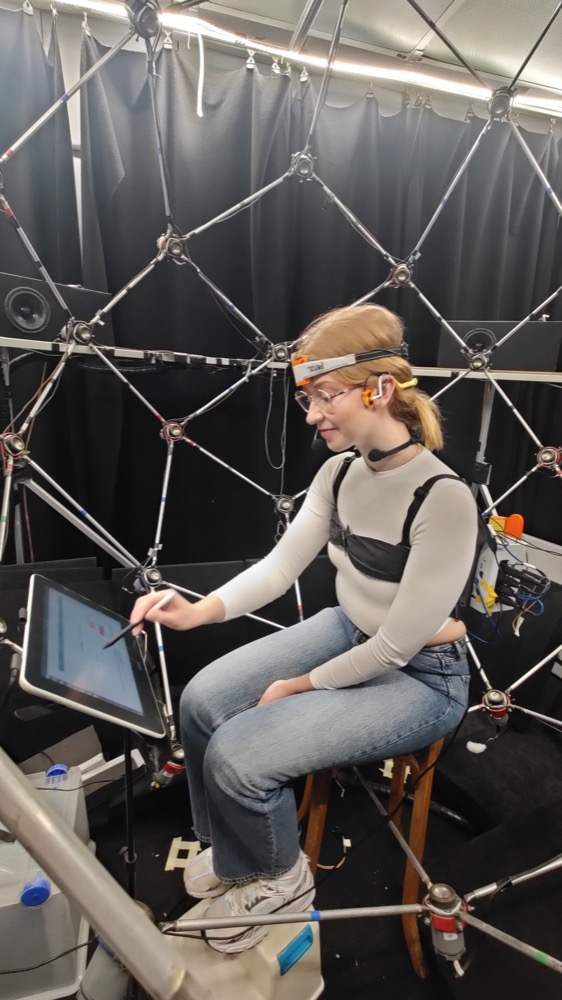

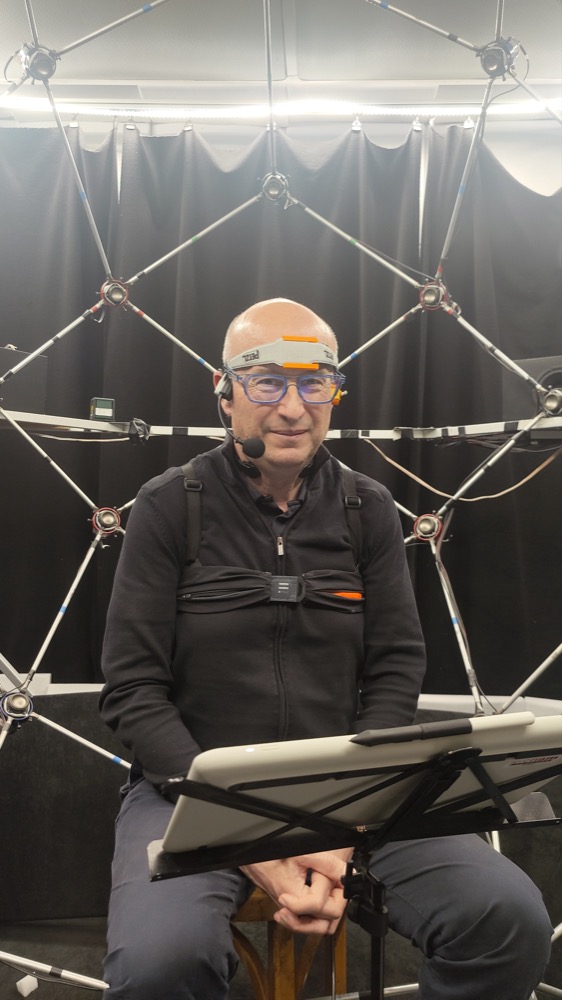

Participants portant les capteurs :

Détail des capteurs :

Sous-sections de Capteurs audio

Microphone de référence

Référence

La référence du microphone à conduction aérienne est Shure WH20XLR.

Ce microphone est disponible à la vente sur thomann. La documentation technique se trouve ici.

Microphone intra-auriculaire rigide

Référence

Ce microphone intra-auriculaire rigide est intégré dans le produit Acoustically Transparent Earpieces fabriqué par l’entreprise allemande inear.de.

Les détails techniques sont reportés dans la publication A one-size-fits-all earpiece with multiple microphones and drivers for hearing device research. Dans le cadre du dataset VibraVox, nous avons seulement utilisé le microphone intra-auriculaire Knowles SPH1642HT5H-1 top-port MEMS dont la documentation technique est disponible sur Knowles.

Microphone intra-auriculaire souple

Référence

Ce microphone est un prototype réalisé conjointement par l’entreprise Cotral, l’ISL (Institut franco-allemand de recherches de Saint-Louis) et le LMSSC (Laboratoire de Mécanique des Structures et des Systèmes Couplés). Il consiste en un embout Alvis mk5 associé à un microphone STMicroelectronics MP34DT01. Plusieurs mesures ont été entreprises pour garantir une étanchéité acoustique optimale pour le microphone intra-auriculaire afin de choisir l’embout le plus adapté.

Pré-amplification

Ce microphone a nécessité un circuit de pré-amplification.

Laryngophone

Référence

La référence du Laryngophone Dual Transponder Throat Microphone - 3.5mm (1/8") Connector - XVTM822D-D35 fabriqué par ixRadio. Ce microphone est disponible à la vente sur ixRadio.

Accéléromètre frontal

Référence

Pour offrir une grande variété de microphones à conduction corporelle, nous avons incorporé un accéléromètre Knowles BU23173-000 positionné sur le front et fixé en place à l’aide d’un bandeau personnalisé imprimé en 3D.

Préamplification

Un préamplificateur dédié a été développé pour ce capteur.

Maintien en position

Le bandeau conçu s’inspire de la conception d’une lampe frontale. Une pièce personnalisée imprimée en 3D a été nécessaire pour adapter le capteur au bandeau.

Capteur de vibrations temporal

Référence

La référence du microphone de contact sur la tempe est C411 fabriqué par AKG. Ce microphone est disponible à la vente sur thomann. Il est généralement utilisé pour les instruments à cordes, mais le projet VibraVox l’utilisera comme microphone à conduction osseuse.

Maintien en position

Ce microphone est placé sur la tempe à l’aide d’une pièce imprimée en 3D. Le design de cette pièce a été basé sur un scan 3D du casque Aftershokz, avec les modifications nécessaires pour accueillir le capteur avec un lien sphérique.

Enregistreur

Référence

Tous les microphones ont été connectés à un enregistreur multipiste Zoom F8n pour un enregistrement synchronisé.

Paramètres

| Microphone | Piste | Gain (dB) | Fréquence de coupure du filtre passe haut (Hz) | Limiteur | Alimentation fantôme |

|---|---|---|---|---|---|

| Tempe | 1 | 65 | 20 | Advanced mode | ✅ |

| Laryngophone | 2 | 24 | 20 | Advanced mode | ✅ |

| Intra-auriculaire rigide | 3 | 20 | 20 | Advanced mode | ✅ |

| Intra-auriculaire souple | 5 | 30 | 20 | Advanced mode | ✅ |

| Frontal | 6 | 56 | 20 | Advanced mode | ✅ |

| Aérien | 7 | 52 | 20 | Advanced mode | ❌ |

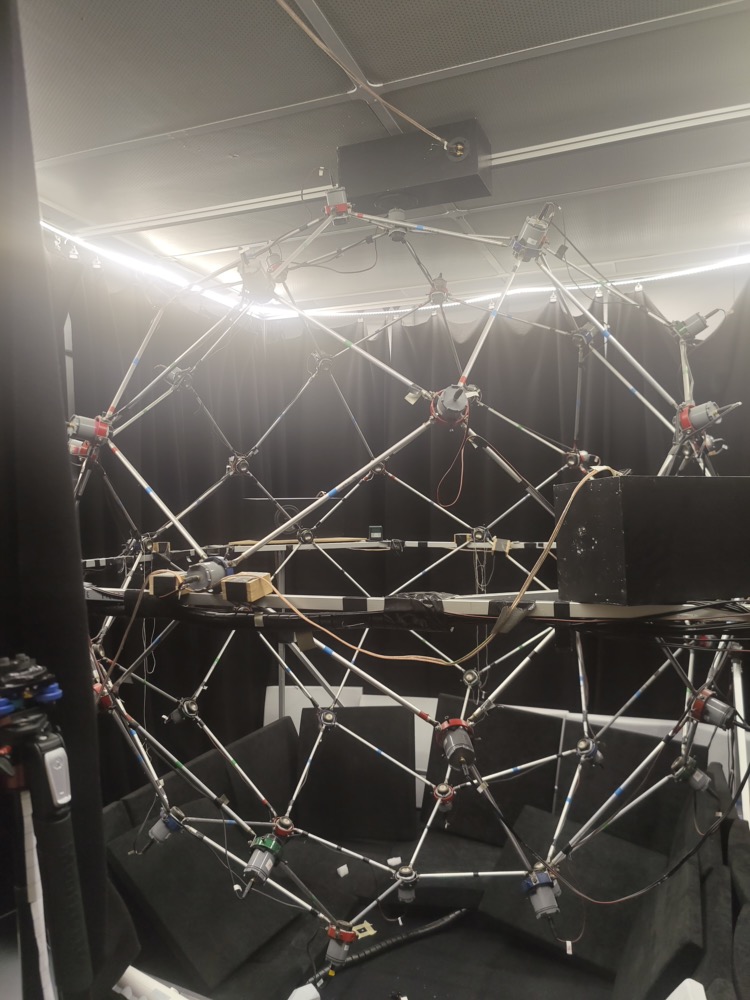

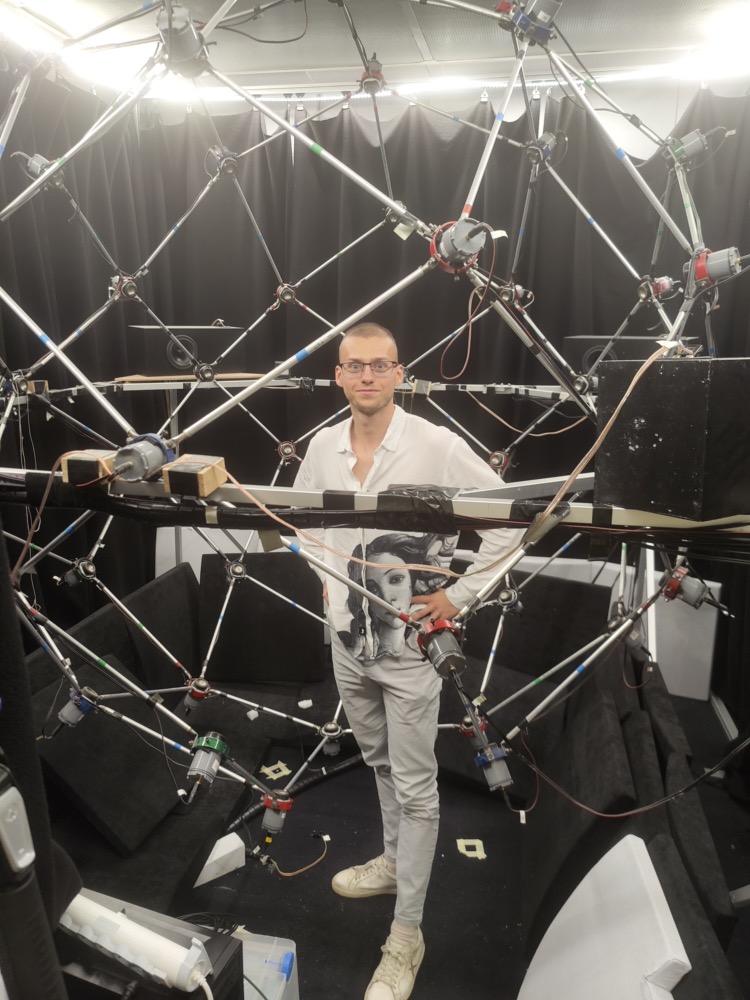

Spatialisateur sonore

Pour tous les échantillons de bruit ambiant utilisés dans l’ensemble de données, le processus de spatialisation a été effectué en utilisant la sphère de spatialisation sonore 3D Spherebedev développée au cours de la thèse de Pierre Lecomte dans notre laboratoire, et la bibliothèque ambitools, également développée par Pierre Lecomte au cours de sa thèse de doctorat au Cnam.

Le système Spherebedev est un réseau de haut-parleurs sphériques d’un rayon de 1,07 mètre, composé de 56 haut-parleurs placés autour des participants. Pour assurer une spatialisation précise de l’ensemble de la gamme audio, deux systèmes imbriqués ont été utilisés :

- Un système basse fréquence avec 6 haut-parleurs haute performance (ScanSpeak, jusqu’à 200 Hz) pour une reproduction précise des basses.

- Un système haute fréquence composé de 50 haut-parleurs (Aura, 2 pouces, pour les fréquences supérieures à 200 Hz).

Les fichiers audio multicanal utilisés pour la resynthèse ambisonique d’ordre supérieur comprennent des enregistrements ambisoniques d’ordre 3 captés à l’aide d’un microphone Zylia ZM-1S et des enregistrements ambisoniques d’ordre 5 captés à l’aide du Memsbedev, un prototype de microphone ambisonique développé au laboratoire LMSSC.

Logiciel

Parcourez tous les détails du logiciel utilisé pour le projet Vibravox.

Sous-sections de Logiciel

Frontend

L’interface, construite avec la bibliothèque tkinter, consiste en 9 fenêtres séquentielles. L’interface utilisateur est dupliquée sur une tablette Wacom utilisée par le participant au centre de la sphère de spatialisation. Plusieurs threads ont été nécessaires pour permettre des actions simultanées, telles que la mise à jour d’une barre de progression en attendant qu’un bouton soit cliqué.

Backend

La partie backend comprend:

-

Un lecteur dynamique implémenté avec la bibliothèque linecache pour éviter de charger l’ensemble du corpus en mémoire lors de l’obtention d’une nouvelle ligne de texte.

-

Un module de cryptographie utilisant cryptography.fernet pour crypter et décrypter l’identité des participants, nécessaire pour faire valoir le droit à l’oubli.

-

Un client ssh construit avec paramiko pour envoyer des instructions à la sphère de spatialisation lors de la lecture du son, du changement de piste, et de la localisation de la tête de lecture avec les commandes bash jack_transport et ladish_control.

-

Un timer avec des méthodes de démarrage, de pause, de reprise et de réinitialisation.

-

Un enregistreur de flux non bloquant implémenté avec les bibliothèques sounddevice, soundfile et queue.

Bruit

Bruit pour l’étape QiN

Sélection

Après voir uniformisé la fréquence d’échantillonage, les canaux et le format des fichiers d’AudioSet. Le bruit monocanal est obtenu à partir de 32 échantillons de 10 secondes des 90 classes suivantes :

[‘Drill’, ‘Truck’, ‘Cheering’, ‘Tools’, ‘Civil defense siren’, ‘Police car (siren)’, ‘Helicopter’, ‘Vibration’, ‘Drum kit’, ‘Telephone bell ringing’, ‘Drum roll’, ‘Waves, surf’, ‘Emergency vehicle’, ‘Siren’, ‘Aircraft engine’, ‘Idling’, ‘Fixed-wing aircraft, airplane’, ‘Vehicle horn, car horn, honking’, ‘Jet engine’, ‘Light engine (high frequency)’, ‘Heavy engine (low frequency)’, ‘Engine knocking’, ‘Engine starting’, ‘Motorboat, speedboat’, ‘Motor vehicle (road)’, ‘Motorcycle’, ‘Boat, Water vehicle’, ‘Fireworks’, ‘Stream’, ‘Train horn’, ‘Foghorn’, ‘Chainsaw’, ‘Wind noise (microphone)’, ‘Wind’, ‘Traffic noise, roadway noise’, ‘Environmental noise’, ‘Race car, auto racing’, ‘Railroad car, train wagon’, ‘Scratching (performance technique)’, ‘Vacuum cleaner’, ‘Tubular bells’, ‘Church bell’, ‘Jingle bell’, ‘Car alarm’, ‘Car passing by’, ‘Alarm’, ‘Alarm clock’, ‘Smoke detector, smoke alarm’, ‘Fire alarm’, ‘Thunderstorm’, ‘Hammer’, ‘Jackhammer’, ‘Steam whistle’, ‘Distortion’, ‘Air brake’, ‘Sewing machine’, ‘Applause’, ‘Drum machine’, “Dental drill, dentist’s drill”, ‘Gunshot, gunfire’, ‘Machine gun’, ‘Cap gun’, ‘Bee, wasp, etc.’, ‘Beep, bleep’, ‘Frying (food)’, ‘Sampler’, ‘Meow’, ‘Toilet flush’, ‘Whistling’, ‘Glass’, ‘Coo’, ‘Mechanisms’, ‘Rub’, ‘Boom’, ‘Frog’, ‘Coin (dropping)’, ‘Crowd’, ‘Crackle’, ‘Theremin’, ‘Whoosh, swoosh, swish’, ‘Raindrop’, ‘Engine’, ‘Rail transport’, ‘Vehicle’, ‘Drum’, ‘Car’, ‘Animal’, ‘Inside, small room’, ‘Laughter’, ‘Train’]

Cela représente 8 heures d’audio.

Normalisation de l’intensité sonore

from ffmpeg_normalize import FFmpegNormalize

normalizer = FFmpegNormalize(normalization_type="ebu",

target_level = -15.0,

loudness_range_target=5,

true_peak = -2,

dynamic = True,

print_stats=False,

sample_rate = 48_000,

progress=True)

normalizer.add_media_file(input_file='tot.rf64',

output_file='tot_normalized.wav')

normalizer.run_normalization()Spatialisation

La direction du son est samplé uniformément sur la sphère unité en utilisant lafonction répartition inverse.

Bruit pour l’étape SiN

Le bruit utilisé pour l’étape finale de l’enregistrement a été capté avec une ZYLIA ZR-1 Portable. Il est composé d’applaudissements, de manifestations et d’opéra pour un total de 2h40.

Protocole d'enregistrement

Procédure

Le processus d’enregistrement se déroule en quatre étapes :

-

Speak in Silence : Pendant 15 minutes, le participant lit des phrases tirées de la Wikipédia française. Chaque énoncé génère un nouvel enregistrement et les transcriptions sont conservées.

-

Quiet in Noise : Pendant 2 minutes et 24 secondes, le participant reste silencieux dans un environnement bruyant créé à partir des échantillons AudioSet. Ces échantillons ont été sélectionnés dans des classes pertinentes, normalisés en intensité sonore, pseudo-spatialisés et sont joués depuis des directions aléatoires à l’aide d’une sphère de spatialisation équipée de 56 haut-parleurs. L’objectif de cette phase est de recueillir des bruits de fond réalistes qui seront combinés avec les enregistrements Parler en silence pour maintenir une référence propre.

-

Quiet in Silence : La procédure est répétée pendant 54 secondes dans un silence complet afin d’enregistrer uniquement les bruits physiologiques et les bruits du microphone. Ces échantillons peuvent être utiles pour des tâches telles que le suivi de la fréquence cardiaque ou simplement l’analyse des propriétés de bruit des différents microphones.

-

Speak in Noise : La phase finale (54 secondes) servira principalement à tester les différents systèmes (amélioration de la parole, reconnaissance automatique de la parole, identification du locuteur) qui seront développés sur la base des enregistrements des trois premières phases. Ce test en conditions réelles fournira des indications précieuses sur les performances et l’efficacité de ces systèmes dans des scénarios pratiques. Le bruit a été enregistré à l’aide de l’enregistreur portable ZYLIA ZR-1 à partir de scènes spatialisées et rejoué dans la sphère de spatialisation avec un traitement ambisonique.

Post traitement

Veuillez vous référer à l’article scientifique décrivant Vibravox pour plus d’informations sur le traitement des données mesurées.

Analyse

Fonctions de cohérence

Les fonctions de cohérence de tous les microphones sont représentés sur la Figure ci-dessous lors d’une phase active de parole.

Formulaire de consentement

Assurer la conformité avec le GDPR

Un formulaire de consentement pour la participation au jeu de données VibraVox a été rédigé et approuvé par le juriste du Cnam. Ce formulaire mentionne que le jeu de données sera publié sous la licence Creative Commons BY 4.0, qui permet à quiconque de partager et d’adapter les données à condition que les auteurs originaux soient cités. Toutes les exigences de la Cnil ont été vérifiées, y compris le droit à l’oubli. Ce formulaire doit être signé par chaque participant à VibraVox.

Le formulaire de consentement

Les enregistrements vocaux recueillis lors de cette expérience ont pour objectif de servir la recherche sur les microphones résistants au bruit, dans le cadre du projet de thèse de M. Julien HAURET, chercheur doctorant au Conservatoire national des arts et métiers (Cnam) (julien.hauret@lecnam.net). Ce formulaire a pour but de recueillir le consentement de chacun des participants à ce projet à la collecte et à la conservation de leurs enregistrements vocaux, nécessaires à la production des résultats de ce projet de recherche. Les enregistrements collectés seront anonymisés et partagés publiquement à l’adresse vibravox.cnam.fr sous licence Creative Commons BY 4.0, étant précisé que cette licence permet à quiconque de partager et d’adapter vos données. Ce traitement de données à caractère personnel est enregistré dans un fichier informatisé par le Cnam. Ces données pourront être conservées par le Cnam pour une période allant jusqu’à 50 ans. Les destinataires des données récoltées seront le chercheur doctorant précité ainsi que son directeur de thèse M. Éric Bavu. Conformément au règlement général relatif à la protection des données UE 2016/679 (RGPD) et des lois n° 2018-493 du 20 juin 2018 relative à la protection des données personnelles et n° 2004-801 du 6 août 2004 relative à la protection des personnes physiques à l’égard des traitements de données à caractère personnel et modifiant la loi n° 78-17 du 6 janvier 1978 relative à l’informatique, aux fichiers et aux libertés, vous disposez d’un droit d’accès, de rectification, d’opposition, d’effacement, de limitation et de portabilité concernant les données personnelles vous concernant, soit vos enregistrements vocaux. Pour exercer ces droits ou pour toute question sur le traitement de vos données dans ce dispositif, vous pouvez contacter l’adresse vibravox@cnam.fr. Même si votre droit à l’oubli reste applicable pendant toute la durée de conservation des données, nous vous conseillons de le faire valoir avant la publication définitive de la base de données qui est prévue le 01/10/2023. Si vous estimez, après nous avoir contactés, que vos droits ne sont pas respectés, vous pouvez directement contacter la déléguée à la protection des données du Cnam-établissement public à l’adresse ep_dpo@lecnam.netonmicrosoft.com. Une réclamation peut être introduite auprès de la Cnil.